简析AI(深度学习)

来源:原创 时间:2017-10-26 浏览:0 次从20世纪60年代开端,人们就在等待像哈尔(HAL)这样的科幻等级的AI,可是直到最近,PC和机器人仍是十分愚笨。现在,科技巨子和创业公司宣告了AI革新的到来:无人驾驭轿车、机器人医生、机器出资者等等。普华永道以为,到2030年,AI将会向国际经济奉献15.7万亿美元。“AI”是2017年的热词,就像“.com”是1999年的时尚用语那样,每一个人都宣称自己对AI感兴趣。不要被有关AI的炒作所利诱,它是泡沫仍是实在?和旧有的AI潮流比较,它现在有什么新颖之处?

AI并不会简略或敏捷地被运用。最令人兴奋的AI实例往往来自大学或许科技巨子。任何承诺用最新的AI技术让公司发作革新性革新的自封的AI专家,都仅仅在传递过错的AI信息,其间某些人仅仅重塑旧有技术的形象,把它们包装成AI。每个人都现现已过运用Google、微软、亚马逊的效劳,来体会了最新的AI技术。可是,“深度学习”不会敏捷地被大企业所把握,用来定制内部项目。大多数人都缺少满足的相关数字数据,不足以牢靠地用来练习AI。成果就是,AI并不会杀死一切的作业时机,特别由于它在练习和测验每个AI的时分仍是需求人类。

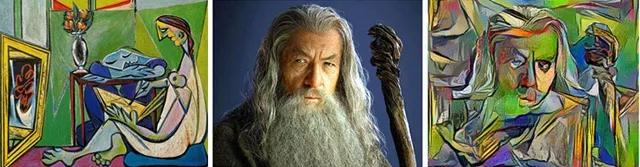

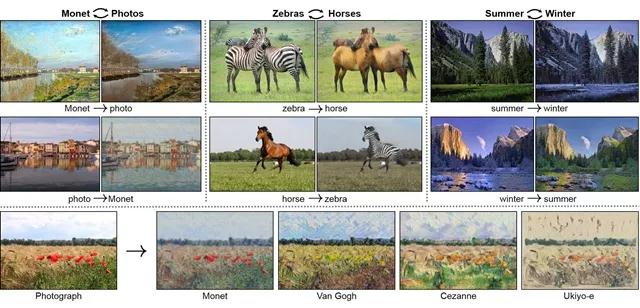

AI现在现已能够“用眼睛看到”,并通晓一些视觉相关的作业了,比方:经过医学影像辨认癌症或其他疾病,在核算学上优于人类放射科医生、眼科医生、皮肤科医生等,还有驾驭轿车、读唇语。AI能经过学习样本(比方毕加索或许你的画作)画出任何一种风格的图画。反过来,它也能经过一幅画,补足缺失的信息,猜出实在的相片是什么。AI看着网页或运用的屏幕截图,就能写出代码制作出相似的网页或运用。

AI现在还能“用耳朵听到”,它不只能听懂你的话,还能经过听Beatles或你的音乐,创造出新的音乐,或许仿照它听到的任何人的声响。一般人无法分辨出一幅画或一首曲子是由人仍是由机器创造的,也无法分辨出一段话是由人类仍是AI说出的。

被练习用来赢得扑克竞赛的AI学会了故弄玄虚,能够处理丢牌、潜在的造假行为,还能误导信息。被练习用来商洽的机器人也学会了诈骗,能猜想出你什么时分在扯谎,如果需求它们也会说谎。一个用来在日语和英语间翻译或许在韩语和英语间翻译的AI,也能在韩语和日语间进行翻译变换。看起来翻译AI自己创造了一种中心言语,能不分言语的边界演绎任何一个语句。

机器学习(ML)是AI的一个子类别,它能让机器从阅历中学习,从实在国际的实例中学习,数据量越大,它就能学到越多。听说,如果一台机器完结一项使命的表现跟着阅历的增多越来越好,那它就能依据这项使命的阅历进行学习。但大部分AI仍是依据固定规矩制造出来的,它们并不能学习。从现在开端,我将运用“机器学习”这个词来指称“从数据中进行学习的AI”,以此着重它和其他AI的差异。

人工神经网络仅仅通往机器学习的其间一种办法,其他途径还包含决策树、支撑向量机等。深度学习是一种具有许多笼统层次的人工神经网络。不去谈“深度”这个有炒作意味的词,许多机器学习办法都是“粗浅的”。成功的机器学习一般是混合的,也就是许多办法的组合,比方树+深度学习+其他,它们都是被别离练习而成的,再把它们结合在一同。每一个办法都可能带来不同的过错,所以,均匀了它们每一个办法成功的成果,它们就胜过了独自一种办法。

旧有的AI并不能“学习”。它是依据规矩的,它仅仅几个人类写成的“如果……那么……”。它只需能处理问题就被称作是AI,但它不是机器学习,由于它不能从数据中进行学习。现在的AI和主动体系中大部分仍然是依据规矩的代码。机器学习从20世纪60年代开端才被人了解,但就像人类大脑一样,它需求许多的核算设备处理许多的数据。在20世纪80年代,要在PC上练习一个ML需求几个月时间,而那时分的数字数据也十分稀疏。手动输入的依据规矩的代码能快速地处理大部分问题,所以机器学习就被遗忘了。但用我们现在的硬件,你能在几分钟内就练习出一个ML,我们知道最佳的参数,并且数字数据也更多了。然后在2010年之后,一个又一个AI范畴开端被机器学习所掌控,从视觉、语音、言语翻译到玩游戏,机器学习胜过了依据规矩的AI,并且一般也能胜过人类。

为什么AI在1997年的国际象棋竞赛中就打败了人类,但直到2016年,才在围棋竞赛中打败了人类呢?由于在1997年,核算机仅仅简略地核算出了国际象棋8×8棋盘中一切的可能性,但围棋具有19×19的可能性,核算机要核算出一切可能性需求十亿年。这就像要随机组合出一切字母,以此得到这样一整篇文章一样:这根本不行能。所以,人们已知的仅有的期望在于练习出一个ML,可是ML是近似的,不是断定的,机器学习是“随机的”,它能够被用于核算剖析的形式,但不能用于精确的猜想。

机器学习让主动化成为可能,只需你准备好练习ML的正确数据就能够了。

大多数机器学习都归于监督学习,这儿用来练习的实例都是有标签的,标签就是关于每个实例的描绘或许标示。你首要需求人工把那些关于猫的相片从关于狗的相片中分离出来,或许把垃圾邮件从正常邮件中分离出来。如果你过错地给数据打了标签,终究ML就会不正确,这至关重要。把未打标签的数据放到ML里,这就是无监督学习,在这儿ML会发现有用的数据的模型和群组,但它不能独自用来处理许多问题。所以有些ML是半监督式的。

在反常检测中,你能够辨认出不同寻常的东西,比方诈骗或许赛博侵略。一个经过旧式诈骗练习出来的ML会错失那些新式的诈骗。你能够让ML对任何可疑的不同之处做出正告。政府部门现已开端用ML来侦办逃税行为了。

强化学习在1983年的电影《战役游戏》中就现已有了表现,在电影里,核算机经过打通光速中的每一个场景,然后避免了第三次国际大战。这个AI在百万计的失利与测验中探究,终究得到了巨大的报答。AlphaGo是这样被练习而成的:它曾数百万次地扮演自己的对手,然后取得逾越人类的技术。它使出了前所未见的招数,人类选手乃至可能会把它看做过错的招数。但后来,这些招数被公以为机敏特殊。ML开端变得比人类围棋选手更赋有创造性。

在人们以为AI不是真实智能的时分,“AI效应”就呈现了。人们在潜意识里需求信任法力,需求信任人类在国际中的绝无仅有。每一次机器在某一项智能活动中逾越了人类时,比方鄙人象棋、辨认图片或许翻译时,人们总是会说:“那仅仅强力核算才干,那不是智能。”许多app里都有AI存在,可是一旦被广泛运用,它就不再被称作“智能”。如果“智能”仅仅AI没有达到的技术(也就是独归于大脑的技术),那字典每一年都要被更新,比方:数学在20世纪50年代之前才被以为是智力活动,现在现已不是了。这真是太奇怪了。关于“强力核算才干”,一个人类大脑具有100万亿个神经元衔接,比地球上任何一个核算机所具有的都多得多。机器学习不能做“强力核算”,如果让机器学习去测验一切衔接,那需求花上十亿年的时间。机器学习只会“在被练习的基础上进行猜想”,并且它运用的核算才干比大脑运用的要少。所以,应该是AI来宣称人类大脑不行智能,来宣称人类大脑仅仅强力核算才干罢了。

机器学习并不是一个人类大脑仿照器,真实的神经元要不同得多。机器学习是通往真实大脑才干的另一条通路。大脑和机器学习都要处理核算数字(概率)来迫临杂乱函数,它们都会给出略微有点误差的成果,但这个成果是可用的。机器学习和人类大脑会针对同一使命给出不同的成果,由于它们以不同的办法处理问题。一切人都知道,大脑简略忘掉作业,并且在处理特定数学问题的时分也有许多约束,但机器在回忆和数学方面是白璧无瑕的。可是,那些以为“机器要么给出切当答案,要么就是机器坏了”的旧主意是过错的、过期了的。人类会犯许多错,你不会听到说这个人类大脑坏掉了,而是会听到让这个人类大脑更努力地学习。所以,ML也不是坏掉了,它们需求更努力地学习,在更多不同的数据中学习。依据人类成见练习出来的ML有可能会是种族主义的、性别歧视的、不公平的,总归最糟糕的仍是人类大脑。ML不应该只被数据练习,不应该只为了仿照人类的作业、行为和大脑。相同的ML,如果在其他星系被练习,就能仿照外星人的大脑,让我们也用外星人的思想来考虑吧。

AI正在变得像人类一样奥秘。那些以为核算机无法具有创造力,不能说谎、犯错或许像人类一样的主意,是来自于旧有的依据规矩的AI,这些AI确实是可猜想的,但它们会跟着机器学习的呈现而发作改动。AI一旦把握了某些新的才干,就被称作“不行智能”,这样的年代现已完毕了,对AI来说,仅有真实重要的差异是:通用AI,或许狭义AI。

和其他科学不同,你无法验证一个ML是否在运用逻辑化的理论。要判别一个ML是否正确,你只能经过测验那些不行见的新的数据成果。ML不是一个黑匣子,你能够看到那些它生成和运转的“如果……那么……”列表,但一般对一个人类来说,这些数据量太大太杂乱了。ML是一门企图重实际际国际之紊乱与人类直觉的有用科学,它不会给出简略的或理论化的解说。这就如同,你有一个行得通的主意,但你不能详细解说出自己是怎样得出这个主意的。关于大脑来说,这被称为创意、直觉、潜意识,但对核算机来说,这就是机器学习。如果你能得到一个人在大脑里做出决议所需的悉数神经信号,你就能了解大脑做出这个决议的真实缘由和进程吗?或许能吧,但这很杂乱。

每个人都能够经过直觉来幻想另一个人的脸,能够是实际的脸也能够是毕加索式的脸。人们还能幻想一种声响或许音乐风格。但没人能用完好而有用的办法来描绘一张脸、声响或许音乐风格的改变。人类只能看到三个维度,即便爱因斯坦也不能有意识地处理500个维度上机器学习一般的数学问题。但我们的人类大脑一向在用直觉处理这种500维的数学问题,就像魔法一样。为什么它不能被有意识地处理呢?想想一下,如果对每个主意,大脑都给出它所运用的有上千个变量的公式,会怎样?那些剩余的信息会让我们十分困惑,并且大幅减缓我们考虑的速度,这又何须呢?没有人类能进行几页长的数学核算,我们的头上并没有进化出USB电缆那样的东西来。

有缺点的主动化会提高人类的作业,而不会杀死这些作业。

如果没有人能猜想任何事,那么机器学习相同做不到。许多人用多年的商场价格改变来练习ML,但这些AI仍是无法猜想商场走向。ML只要在曩昔的要素和趋势坚持不变的状况下进行猜想。但股票和经济趋势常常变化,几乎是随机的。当旧的数据不再有用或许频频呈现过错的真话,ML就会失灵。现已习得的使命和规矩有必要坚持一致,或至少是很少再变化,这样你才干再次练习。举个比方,学习开车、打扑克、按某种风格画画、依据健康数据猜想疾病、在不同言语之间进行变换,这些是机器学习能做到的,旧有的实例在近期未来仍然会是有用的。

机器学习能在数据中找到因果联络,但它找不到并不存在的东西。比方,在一项名为“运用面部图画主动辨认罪犯”的奇怪研讨中,ML学习了许多在押罪犯和无罪者的面部相片,研讨者宣称,机器学习只依据一张面部相片就能抓到新的“坏人”,但研讨者“感觉”,更进一步的研讨将驳回依据相貌进行判别的有用性。他们的数据设置是有成见的:有些看起来无辜的白领罪犯乃至会讪笑他们的做法。ML能学到的仅有联络是开心或生气的嘴巴、领子的类型等。那些微笑着的穿戴白领的人被分类为无辜诚笃的,而那些看起来哀痛的穿黑领衣服的人则和“坏人”相关。那些机器学习专家测验着用人们的面部来判别这个人的好坏,但他们却不能经过穿戴(社会阶层)去判别。机器学习扩大了一种不公平的成见:街上穿戴廉价衣服的小贼比糜烂的政客和尖端企业诈骗者更简略被发现并遭到赏罚。这种机器学习将会发现一切街上的小贼并把他们投入监狱,但一个白领都没有。机器学习并没有像任何一个成年人那样在我们这个国际生活过,它们不知道在数据以外还有什么,连那些很“显着的”也不知道,举个比方:在一场火灾中,火势越大,被派去的救火车就越多。一个ML会注意到,在一个火场的消防员越多,第二天看到这场形成的损坏就越大,所以正是那些救火车导致了火灾损坏。定论:机器学习会以纵火罪把消防员送进监狱,由于这其间有95%的相关性!

(机器学习不能从不存在的东西中寻觅相关性,比方:带有违法倾向的面部。但这些数据是带有成见的:没有微笑着的白领罪犯在其间!机器学习会学到这些成见。)

在某些状况下,机器学习能猜想人类不能猜想的作业。“Deep Patient”是一个由纽约西奈山医院用70万患者数据练习而来的ML,它能用来猜想精神分裂症,而没有任何一个人类了解要怎么猜想!只要ML能够做到,人类无法经过学习机器学习而做到相同的作业。这就是问题所在:对一项出资、医疗、司法和军事决议来说,你可能想知道AI是怎么得出它的定论的,但你无法知道。你无法知道机器学习为什么拒绝了你的借款,为什么断定你入狱,为什么把一个作业时机给了他人。ML公不公平?它是否带有种族、性别和其他成见?机器学习核算是可见的,但它们很难做成人类可阅览的总结。机器学习就像个预言者那样说话:“你们人类不了解,即便我展现给你们数学你们也不懂,所以信仰我吧!你测验过了我以往的猜想,它们都是对的!”

人类也历来不会完好地解说他们所做的决议。我们会给出听起来合理的理由,但却一般是不完好的过于简化的理由。那些总能从ML那里得到正确的答案的人们,会开端假造虚伪的阐释,就是由于这样会让大众更简略认可ML的猜想。还有些人会悄悄运用ML,并把得出的主意说成是他们自己的主意。

ML是有限的,就是由于它们缺少通用智能和事前的知识。即便把一切专业的ML交融在一同,或许练习一个ML做一切作业,它仍然无法完结通用智能的作业。举个比方,拿了解言语来说,你不能和Siri、Alexa或Cortana议论一切论题,就像和真实的人谈天那样,它们仅仅智能帮手。在2011年,IBM的Watson在Jeopardy节目中比人类选手答复得更为敏捷,但它却把加拿大和美国搞混了。ML能够为长文出产出有用的简略总结,包含做出心情剖析,但却不能像人类那样牢靠地完结这项作业。谈天机器人无法了解太多问题。现在也没有任何一个AI能完结对一个人来说很简略的作业:估测一个顾客是否是恼怒的、充溢挖苦的,并进而调整自己的语调。并不存在像电影里那种通用的AI。但我们仍然能够得到一些科幻式AI的细枝末节,也就是那些在某个狭隘专业范畴里胜过人类的AI。最新的音讯是,狭隘范畴也能够包含有创造性的或那些一般被以为只要人类能做的作业,比方绘画、作曲、创造、猜想、诈骗和假造心情等,这些看起来都不需求通用的AI。

没人知道怎么造出一个通用AI。这真是棒极了,我们现已具有了超人类的专业工人(狭义AI),但没有任何一个终结者或黑客帝国会自己决议要杀掉我们。不幸的是,人类会练习机器顷刻间杀掉我们,举例来说,一个恐惧分子可能会练习一个主动驾驭的货车抵触人行道。而具有通用智能的AI可能会自我消灭,也不会遵照恐惧分子的指令。

AI道德可能将被侵略,并且从头编程为不合法的形式。现在的AI既不是通用的也不是归于科学家的AI,它总是会遵照人类的指令。

AI会杀死旧有的作业,但还会创造出新的机器学习练习员的作业,就和宠物练习员有点相似,而不像工程师。一个ML比一向宠物要难练习多了,由于它不具有通用智能,它会学会它从数据中看到的一切东西,不带任何挑选和知识鉴别。一只宠物在学会做坏事之前还会三思而后行,比方说杀死它的小伙伴们之类的。可是对ML来说,它为恐惧分子效劳或为医院效劳没什么差异,并且它也不会解说自己为什么要这样做。ML并不会为自己的过错和它为恐惧分子营建的恐惧空气而抱歉,它究竟不是一般的AI。

有用机器学习练习。如果你用手拿着物品的相片练习一个ML,它会把手看做是这个物品的一部分,也就无法独自辨认出这个物品自身。一只狗知道怎么从人的手上吃东西,而那愚笨的ML则会把食物连同你的手一同吃掉。要改掉这个问题,那就要先练习它知道手,再练习它知道独自的物品,终究练习手拿着物品的状况,并打上标签“手握着物品X”。

版权和知识产权法需求更新。就像人类一样,ML也能创造新的东西。一个ML被展现了现存的A和B两个东西,然后它出产出了C,一个彻底全新的东西。如果C和A、B都满足不同,也和国际上任何其他东西不同,那C就能够取得创造或艺术品的专利。那么谁是这个东西的创造者呢?更进一步,那如果A和B是有专利或许有版权的资料呢?当C十分不同的时分,A和B的创造者就不能以为C是由于A和B的存在而诞生的。我们假设在现有的有版权的绘画、音乐、修建、规划、化学分子式和盗取的用户数据基础上练习ML不合法,那你怎么辨认出一个著作是否运用了ML发生的成果,特别是它并不像毕加索的风格那么简略辨认?你怎样能知道它有没有用一点机器学习呢?许多人都会悄悄运用机器学习,并宣称那些著作是他们自己的。

对一个小公司的大多数作业来说,练习人工要比练习机器学习廉价得多。教一个人类开车很简略,但让机器学会开车去绵长而困难。当然,或许让机器来开车比人类要安全,特别是考虑到那些喝醉了的、疲倦不胜的、看着手机开车的、无视限速的人或许那些赋性张狂的人类。但那么贵重和牢靠的练习只在大公司里有可能存在。用廉价办法练习出来的ML既靠不住又十分风险,但只要很少的公司有才干练习出牢靠的AI。一个受训的ML永久无法被仿制,不像一个大脑的阅历被传送到另一个大脑中那样。大的提供商将会售卖未经练习的ML来完结可重复运用的使命,比方“放射科医生ML”。ML能够弥补一个人类专家,专家总是被需求的,但它能够代替其他“剩余的”职工。一家医院能够聘任一位放射科医生监督ML,而不必聘任许多个放射科医生。放射科医生这个作业并不会灭绝,仅仅在每家医院的作业职位变少了。练习ML的公司将会把ML卖给多家医院,然后赚回出资资金。每一年,练习ML需求的本钱都会下降,由于越来越多人将学会怎么练习ML。但由于数据储藏和测验的原因,牢靠的ML练习终究也不会变得十分廉价。有理论上说,许多作业使命都能够被主动化,但实际上只要一部分作业抵得过练习一个ML的本钱。关于那些过于不寻常的作业,比方泌尿科医生,或许翻译一种古代的现已失传的言语,这样的作业,其人类薪资从长时间来看仍然比一次性练习一个ML来的廉价,由于从事这种作业的人数太少了。

在ML研讨之外,人类仍然会持续从事通用AI的作业,IQ测验是过错的,IQ测验并不能猜想人们在生活中的成功,由于那是十分多不同智能的归纳,视觉、言语、逻辑、人际关系等等,但成果仍然不能用量化的IQ数字来衡量。我们以为,和人类IQ比起来,昆虫是“愚笨的”,但一向以来,蚊子在“咬完就跑”这样一个独自的使命上都胜过了人类。每一个月,AI都在愈加狭隘的使命范畴打败人类,就像蚊子的技术那样狭隘。比及奇点时间降临,AI将在一切作业上打败我们人类,这很可笑。我们正在遇见许多个狭义的奇点,一旦AI在某件事上打败了人类,一切人都等待着那些监督AI的人抛弃他们的作业。我总是读到这样的文章,以为人类将能够保有他们绝无仅有的有缺点的手作业业,但事实上,AI是能够假装有缺点的,它们会学着在每一件制成品中做出手艺一般的不同缺点。要猜想AI下一个会打败什么范畴的人类,这不太可能,AI是有创造力的,但它仍然缺少通用的智能。举个比方:喜剧演员和政客的作业是安全的,尽管他们不需求共同的(狭隘的)学习或学位,但他们就是能够用诙谐和有说服力的作业议论任何作业。如果你的专业是一个杂乱却狭隘的通用使命,比方你是放射科医生,ML就会受训来替代你。你需求具有通用智能!